Als Entwickler ist man ja hellauf begeistert,

wenn die eigene App läuft und alles wie geplant funktioniert.

Leider bekommt man das meist nicht gesagt.

Wenn alles funktioniert, dann wird die App benutzt

und keiner meldet sich.

Nur an der Statistik sieht man, dass alle damit arbeiten.

Die schweigende Mehrheit.

Die wenigen Feedback-Einträge in der App,

die auf Probleme und Fehler hinweisen,

sind folgende:

Ein Student hat zuhause eine zu schlechte Internet-Anbindung.

Auf dem Handy ist etwas zu sehen,

auf dem Computer bleibt der Bildschirm leer.

In der SE App arbeiten wir mit Text, PDF und Audio.

Diese Medien verlangen eine geringere Bandbreite als Video.

Viele Kollegen arbeiten mit Video-Konferenzen, meist mit Zoom.

Studierende mit schlechter Internet-Anbindung sind dann ganz außen vor.

Da auf dem Handy etwas zu sehen ist,

empfiehlt es sich, auf diesem Wege weiter zu machen.

Zum Glück ist die SE App plattform-übergreifend einsetzbar

und läuft auf Handys ebenso wie auf Tablets, Notebooks und Desktops.

In schlecht versorgten Regionen ist der Handy-Empfang meist besser

als Internet über Kupferkabel.

Gerade jetzt in Corona-Zeiten zeigt sich, wie wichtig

der digitale Ausbau Deutschlands ist.

Bei einer Vorlesungsfolie fehlte die Audiodatei.

Dadurch blieb das Autoplay hängen, falls man es eingestellt hatte.

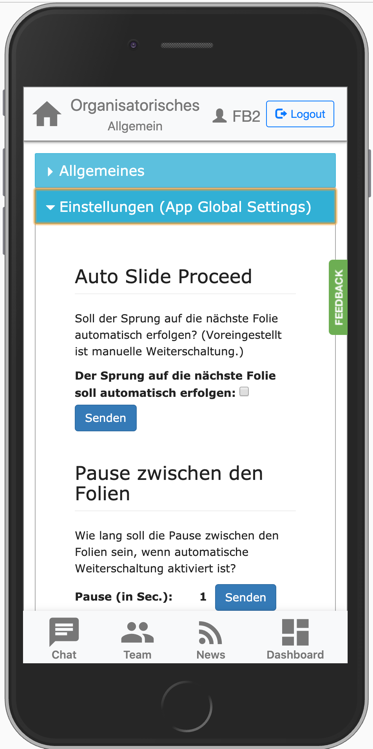

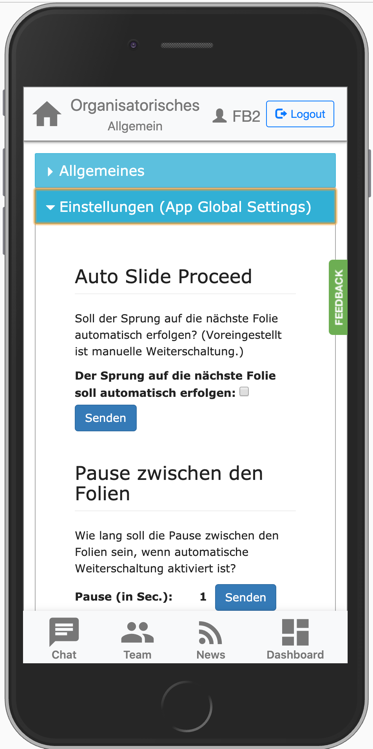

Unter den App-Einstellungen ist es frei wählbar, ob Audio automatisch gestartet

werden soll oder manuell per Tastendruck.

Ebenso kann man einstellen, ob der Sprung zur nächsten Folie

automatisch erfolgen soll nach Fertigstellung der vorherigen Tonspur

(„Auto Slide Proceed“). Dann ist der Unterschied zu einem Video

nicht mehr so groß: Die Slideshow spielt alle Folien von alleine ab.

Allerdings stellt sich die Frage, ob das didaktisch so klug ist.

Ist es nicht besser, die Studierenden müssen manuell weiter schalten?

Dann können Sie noch einmal kurz überlegen, ob sie die letzte

Folie wirklich verstanden haben. Und Fragen unter die Folie schreiben.

Eine solche Pause kann nützlich sein …

Der Student schreibt: „Dabei wäre es in Ordnung wenn es nach 5 sek von alleine Autoplay fortführt.“

Die Lösung war aber einfacher:

Ich habe die fehlende Tonspur hochgeladen.

Als Entwickler bin ich jedenfalls froh, dass die Probleme mit der App eher harmlos sind.